Come funziona ChatGPT e cos’è l’intelligenza artificiale?

L’evoluzione dell’Intelligenza Artificiale (IA) sta influenzando profondamente vari settori, dall’arte alla legge, suscitando meraviglia e incertezza. Recentemente, una rivista scientifica ha documentato l’affermazione di un’IA come vincitrice di un concorso di pittura, mentre autori di nome Beta stanno sfruttando IA per creare articoli. Questa rapida espansione dell’IA lascia molti interrogativi sulla sua portata e significato. Ma come funziona ChatGPT e cos’è davvero un’intelligenza artificiale?

La rapida evoluzione tecnologica ha permesso ai computer di eseguire compiti che prima consideravamo umani. Negli ultimi due anni, l’IA ha dimostrato la sua abilità nel creare arte, mettendo in discussione la definizione stessa di “arte”. Ciò solleva domande riguardo all’essenza dell’arte e se avremo ancora bisogno di artisti umani nel futuro. Inoltre, l’IA sta generando testi legali, scatenando dibattiti sulla necessita di avere avvocati tradizionali.

Ho intrapreso un’indagine approfondita per comprendere le radici delle intelligenze artificiali e il loro funzionamento. Oggi condividerò le mie scoperte, fornendo una panoramica comprensibile per tutti. In particolare, mi concentrerò su ChatGPT, uno dei prodotti di IA più popolari.

ChatGPT: Un Fenomeno Globale

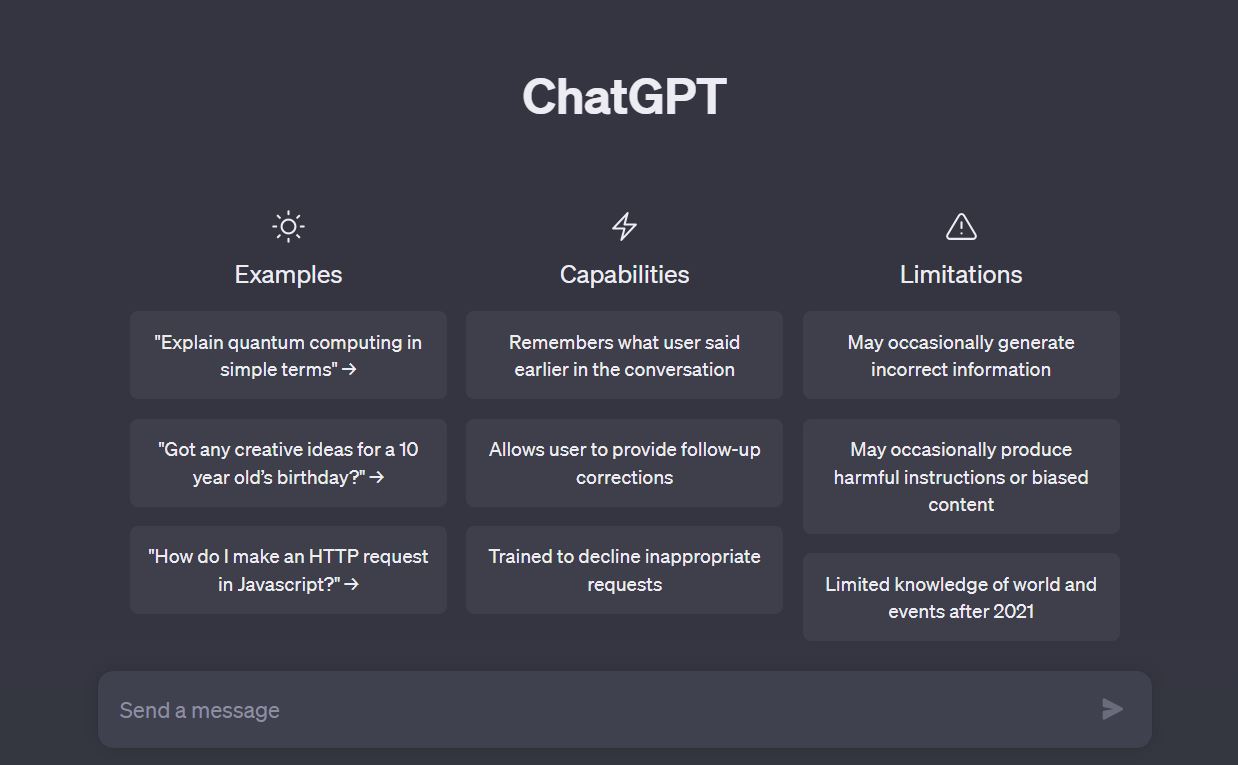

ChatGPT ha ottenuto una sorprendente adesione con 10 milioni di utenti attivi al giorno nel suo primo mese di lancio. Questa piattaforma funziona come un oracolo tecnologico, in grado di rispondere a domande su svariati argomenti. È diventato un’entità di riferimento per risolvere problemi, scrivere testi, creare musica e persino narrare storie originali.

Questa AI si distingue per la sua capacità di conversare e creare contenuti unici e originali, sfidando la tradizionale conoscenza reperibile su Internet. L’IA conversazionale sta dimostrando di essere in grado di superare le aspettative e creare testi che sarebbero stati considerati impossibili solo qualche tempo fa.

Questa rapida evoluzione dell’IA è il risultato di decenni di sviluppo tecnologico convergente, unendo molteplici innovazioni in programmazione e reti di intelligenza artificiale. Questo fenomeno sta portando a una rivoluzione senza precedenti, che ha il potenziale per cambiare radicalmente le dinamiche sociali ed economiche.

Nella mia ricerca su ChatGPT, ho scoperto che questa piattaforma si basa sul modello GPT-3, abbreviazione di “Generative Pre-trained Transformer 3”. Per chiarezza, desidero spiegare cosa sia un modello generativo e come funziona GPT-3.

Modelli Generativi e Analogie

Un modello generativo, come GPT-3, è un algoritmo progettato per replicare il comportamento di un sistema. Ecco alcuni esempi analogici: un modello climatico predice il tempo basandosi sui dati storici, mentre un modello di amp simula l’effetto di un amplificatore per chitarra. Nel caso di GPT-3, è un modello linguistico generativo, focalizzato sulla comprensione e la generazione di testi.

GPT-3 è in grado di prevedere parole in base al contesto. Questo processo è simile all’autocompletamento dei messaggi sui dispositivi mobili, ma GPT-3 è molto più avanzato. Per esempio, se forniamo una parola iniziale, GPT-3 può predire le parole successive che probabilmente verranno utilizzate in un testo coerente. È in grado di generare testi completi e significativi in risposta a input specifici.

ChatGPT: Conversazione e Risposte Condizionate

Una caratteristica distintiva di ChatGPT è la sua configurazione per rispondere come se fosse in una conversazione. Risponde ai testi tenendo conto del contesto, simile a come un interlocutore umano si comporterebbe in una chat. Questo rende le risposte più fluide e coerenti, dando l’impressione di un dialogo autentico.

La principale differenza tra GPT-3 e ChatGPT è nella loro configurazione. Mentre GPT-3 è in grado di completare testi, ChatGPT è progettato specificamente per rispondere in modo coerente alle conversazioni. La piattaforma è basata su GPT 3, anche se talvolta chiamata GPT 3.5 per indicare miglioramenti successivi o GPT 4 per indicare l’ultima versione disponibile.

Questa AI è in grado di completare frasi e rispondere a domande in modo accurato. Può rispondere a varie domande, affermazioni e richieste, dimostrando una notevole abilità di analisi e generazione di testi. Tuttavia, è importante sottolineare che questa apparente “consapevolezza” è il risultato del modello che prevede parole in base al contesto, piuttosto che di un’intelligenza cosciente.

Analisi dell’Interazione con ChatGPT

Ricordo la prima volta che ho utilizzato ChatGPT. Sorprendentemente, rispondeva in modo coerente e riusciva persino a proporre argomenti originali. Ad esempio, chiedendo sull’imperatore romano più malvagio, ha suggerito Caligola, fornendo dettagli sulla sua vita e considerando anche la possibilità di propaganda storica. Questa esperienza ha un effetto quasi magico, ma è essenziale capire che si basa su previsioni di parole.

Mentre la programmazione è un approccio tradizionale per interagire con i computer, ChatGPT offre un modo più accessibile per comunicare con le macchine. Ad esempio, puoi sfruttare ChatGPT anche senza conoscenze di programmazione.

Esplorando come funziona ChatGPT, ho scoperto come questo modello linguistico generativo possa rispondere in modo coerente alle conversazioni. Sebbene sembri capace di sviluppare idee e analizzare dati, è importante ricordare che si basa su previsioni di parole. Nonostante ciò, l’impatto di questa tecnologia è sorprendente e promette di aprire nuove possibilità nell’interazione uomo-macchina.

L’Interazione Uomo-Macchina attraverso il Linguaggio Naturale

Esaminando il modo in cui una macchina opera, ho notato che il processo di interazione uomo-macchina è molto diverso da ciò che sperimentiamo con esseri umani. Per illustrare questa differenza, considero l’esempio dell’uso di una calcolatrice e l’interazione con un essere umano attraverso il linguaggio naturale.

Quando utilizzo una calcolatrice per eseguire operazioni matematiche, devo seguire una sequenza precisa di azioni. Qualsiasi errore nell’inserimento di numeri richiede la correzione dell’input o la ripetizione del processo. Questa rigidità nell’input è tipica delle macchine, che richiedono dati accurati e regole ben definite per eseguire le operazioni.

Al contrario, quando comunico con un essere umano, posso esprimere concetti complessi attraverso il linguaggio naturale. Ad esempio, posso chiedere a un amico di sommare, sottrarre e moltiplicare numeri in una singola frase. Questa capacità di comprendere e analizzare il contesto rende la comunicazione umana più flessibile ed efficace.

ChatGPT: Comprensione e Risposta al Linguaggio Naturale

ChatGPT risolve questa sfida dell’interazione uomo-macchina attraverso il linguaggio naturale. Quando comunico con ChatGPT, sembra capire il contesto della conversazione e risponde in modo coerente. Questo livello di comprensione sembra quasi “consapevole”, ma in realtà è il risultato delle previsioni di parole in base al contesto.

Questa così come altre piattaforme simili si basano su reti neurali. Queste reti sono il cuore dell’apprendimento automatico e sono progettate per imparare compiti complessi che le istruzioni tradizionali non possono affrontare in modo efficace.

Apprendimento Automatico: L’Approccio all’Incertezza

L’apprendimento automatico è l’approccio che utilizziamo per far imparare alle macchine cose che non sappiamo spiegare dettagliatamente. Ad esempio, riconoscere numeri scritti a mano o interpretare disegni complessi sono compiti difficili da spiegare passo dopo passo a un programma tradizionale.

Le reti neurali, come quelle utilizzate da ChatGPT, apprendono studiando molti esempi. Addestriamo una rete neurale a riconoscere gatti in immagini, numeri scritti a mano o persino a giocare a giochi da tavolo. Questo processo è chiamato “training”, in cui l’IA studia migliaia di casi per identificare schemi e dettagli che possono sfuggire a noi umani.

L’apprendimento automatico permette alle intelligenze artificiali di estrapolare informazioni dai dati. Questo processo di addestramento consente all’IA di riconoscere cose che potrebbero sembrare ovvie per noi, ma che sono complesse da spiegare. Ad esempio, addestrare un’IA a riconoscere il testo scritto a mano richiede di fornire migliaia di esempi di scritture diverse.

Studiare l’apprendimento automatico e il funzionamento delle reti neurali rivela l’incredibile potenziale e la complessità dietro le intelligenze artificiali come ChatGPT. Questi sistemi sono in grado di imparare da dati e trarre conclusioni, ma è importante ricordare che le loro “risposte consapevoli” derivano dall’analisi di dati piuttosto che da un’intelligenza propria. L’apprendimento automatico è una via promettente per affrontare sfide complesse e sconosciute, ma richiede un’analisi critica e un’attenzione costante per comprendere appieno le capacità e i limiti di queste tecnologie.

GhatGPT: Dall’Immagine al Linguaggio

Ora vedremo come il linguaggio naturale è trattato dalle macchine, mettendo in luce le sfide di interpretare e comprendere il contesto delle parole. Scopriremo come la tokenizzazione e l’approccio basato sui numeri sono essenziali nel processo di interazione uomo-macchina.

Dopo aver discusso dell’uso di reti neurali nel processo di apprendimento automatico, ho introdotto il concetto di tokenizzazione. Anche se possiamo comprendere il significato di parole come “albero” o “macchina”, le macchine trattano le parole come numeri, codificandole per l’elaborazione. Questo processo è analogo alla rappresentazione numerica delle immagini, dove pixel e colori diventano numeri per la macchina.

Tuttavia, affrontiamo una sfida significativa nel linguaggio naturale: il computer non capirà mai il significato intrinseco di parole come “macchina” o “albero”. Non può immaginare l’aspetto di questi oggetti o coglierne la complessità sensoriale. Questa limitazione deriva dal fatto che le macchine comprendono solo numeri binari (zero e uno) e trattano ogni input come operazioni matematiche.

La conversione di parole in numeri è resa possibile da codifiche come l’ASCII e l’UTF-8. Questi sistemi associano valori numerici a caratteri e simboli. Ad esempio, la parola “cane” è rappresentata da una sequenza numerica specifica. Anche spazi e emoji sono codificati come numeri, semplificando l’elaborazione dei dati da parte delle macchine.

Il Confronto tra Reti Neurali e Testo Umano

Mentre le reti neurali possono riconoscere modelli nei dati, è importante comprendere che ciò che la macchina vede non è alberi o case, ma solo schemi numerici. Affrontiamo il problema di far corrispondere questi schemi a concetti umani complessi. Questo confronto tra reti neurali e linguaggio umano rivela il divario tra l’elaborazione numerica delle macchine e la comprensione intrinseca umana.

Nel processo di creazione di un programma di apprendimento automatico per il linguaggio naturale, affrontiamo l’esercizio mentale di lavorare con token. Ogni token rappresenta una parola o una parte di essa. La rete neurale cerca schemi all’interno dei dati, identificando sequenze numeriche che si ripetono. Questi schemi numerici, o token, rappresentano i concetti che intendiamo comunicare.

La tokenizzazione semplifica i dati e crea una lista di token riconoscibili dalla macchina. Questo passo è cruciale per far lavorare le reti neurali nell’ambito del linguaggio naturale. Tuttavia, è importante sottolineare che questi token non rappresentano concetti, oggetti o realtà, ma solo modelli numerici.

Limiti dell’Interpretazione dei Token

Mentre possiamo creare questa lista di token, il computer non può attribuire significato intrinseco ai token stessi. Non sa che “albero” è un essere vivente con foglie o che “macchina” è un veicolo metallico. L’IA può solo riconoscere schemi numerici che associamo a parole, ma non ha la comprensione intuitiva delle parole stesse.

La questione fondamentale è come associare questi token a oggetti reali. Gli sviluppatori creano connessioni tra token e parole attraverso l’addestramento delle reti neurali. Questo processo è complesso e richiede l’analisi di molti esempi. Nonostante questa associazione, la macchina non “sa” cosa sia un albero o una macchina, ma ha appreso a riconoscere schemi associati a questi concetti.

L’Analogia dei Marcatori

Utilizzeremo l’analogia dei marcatori per spiegare come funziona ChatGPT e come il modello GPT possa associare e riconoscere schemi all’interno dei dati linguistici. I marcatori, o token, svolgono un ruolo cruciale nell’associare concetti tra loro. Ad esempio, i token “regina” e “principessa” spesso si trovano vicini, proprio come “ragazza” o “donna”. Questi marcatori simili vengono contrassegnati per indicare la loro correlazione. Analogamente a un’indagine, dove si segnano indizi durante la ricerca, i marcatori sono segni che indicano associazioni tra parole.

Attraverso l’incorporamento, i modelli di linguaggio possono riconoscere relazioni semantiche tra le parole. Ad esempio, se “regina” e “principessa” condividono marcatori, e lo stesso avviene per “vestito” e “mangiare”, il modello inizia a costruire connessioni tra concetti. Tali associazioni non indicano una comprensione intrinseca, ma mostrano modelli numerici di correlazioni.

Per creare un modello di associazione tra concetti, possiamo addestrare l’IA su un vasto corpus di testi, come centinaia di libri. Il modello individua schemi e associazioni nei dati, catalogando i marcatori comuni tra parole. Ad esempio, parole come “regina” e “principessa” potrebbero essere raggruppate insieme, così come “cane” e “gatto”.

Le Relazioni tra Token

Immaginiamo i marcatori come pennarelli che colorano i collegamenti tra le parole. In un’approssimazione tridimensionale, i marcatori creano una sorta di mappa spaziale di concetti. Questo approccio consente di individuare parole simili o correlate in base alle loro distanze nello spazio. Operazioni matematiche possono essere eseguite su queste relazioni, ad esempio, sottrarre il concetto “donna” da “regina” per ottenere “re”.

L’incorporamento rappresenta le parole attraverso vettori numerici, dove ogni dimensione rappresenta un marcatori specifico. Questo vettore di 300 dimensioni contiene informazioni sulla relazione di ogni parola con gli altri concetti. Questi vettori possono essere considerati come il “DNA” delle parole, contenendo caratteristiche comuni.

Mentre i marcatori sono inizialmente legati a singole parole, il modello di linguaggio può anche considerare sequenze di token, ovvero frasi. Ad esempio, la frase “il gatto dorme sul divano” è rappresentata da una serie di marcatori collegati. Queste frasi sono organizzate nello stesso spazio tridimensionale, ma con una maggiore complessità.

All’interno dello spazio dell’incorporamento, frasi e sequenze di token vengono organizzate con relazioni tra loro. GPT utilizza più di mille marcatori per rappresentare ogni frase, creando un sistema complesso di etichettature e associazioni. Questo processo consente a GPT di creare una mappa delle relazioni tra parole e frasi.

Ottimizzazione dei Testi

Normalizzazione e lemmatizzazione sono processi chiave per ottimizzare i testi. Queste tecniche riducono il rumore nei dati e semplificano le frasi. Ad esempio, eliminiamo parole generiche come “in”, “e”, “lui”, che apportano poco valore. Questi termini spesso non contribuiscono significativamente al contesto.

Un passo ulteriore è la lemmatizzazione, che riduce le parole alle loro forme base. Ad esempio, i verbi vengono portati all’infinito, semplificando il testo. Ad esempio, la frase “il gatto dorme sul divano” potrebbe essere semplificata in “gatto dormire divano”. Questo passo è simile a pulire un pesce, rimuovendo le parti inutili e lasciando solo ciò che conta.

GPT rappresenta testi attraverso sequenze di marcatori numerici compressi. Quando GPT genera risposte, attinge da queste sequenze all’interno del suo spazio di incorporamento. Queste sequenze vengono poi ricostruite in testi umani accettabili, conformi alle regole sintattiche e grammaticali. Tuttavia, poiché il processo di ricostruzione è basato su marcatori compressi, potrebbero esserci differenze rispetto al testo originale.

Generazione di Testi Unici

Un punto interessante è che la generazione di testi da parte di ChatGPT produce risultati unici. Questo accade perché il modello genera testi basati sui dati compressi dei marcatori nel suo spazio di incorporamento. Durante il processo di ricostruzione, il modello potrebbe aggiungere, modificare o rimuovere parole, poiché le sequenze dei marcatori non conservano tutte le informazioni del testo originale. Questo contribuisce alla creazione di testi unici.

Il processo di generazione di testi da parte di ChatGPT è simile alla comunicazione umana. Quando spiego qualcosa a qualcuno, il ricevente non ripeterà esattamente le mie parole, ma esprimerà le stesse idee con parole sue. Lo stesso vale per ChatGPT: il modello ricostruisce i testi in base alle informazioni contenute nei marcatori compressi, ma le parole potrebbero variare per adeguarsi alla struttura grammaticale e al contesto.

Oltre alla normalizzazione e alla lemmatizzazione, ChatGPT utilizza anche il campionamento per generare testi unici. Il campionamento è una tecnica che introduce una dose di casualità nella generazione dei testi. Questo aiuta a evitare una ripetizione esatta delle stesse risposte e contribuisce alla varietà e all’originalità delle risposte generate dal modello.

Il Concetto di Creatività

ChatGPT possiede una sorta di creatività attraverso il campionamento casuale, ma vediamo meglio come funziona ChatGPT. Questo processo è analogo a lanciare un dado: il modello genera un numero casuale e si sposta leggermente all’interno dello spazio dell’incorporamento in base a questo numero. Ciò lo porta a selezionare frasi diverse che sono coerenti con la conversazione in corso.

Utilizzando il campionamento casuale, ChatGPT è in grado di generare risposte che sembrano coerenti con il contesto e le conversazioni precedenti. Anche se le risposte sono nuove combinazioni di storie già apprese durante l’allenamento, il modello è in grado di restituire testi che si collegano bene al contesto e mantengono la coerenza.

Memoria nelle Reti Neurali e Fasi dell’Allenamento

Passiamo ora a un problema importante legato alle fasi delle reti neurali: la memoria. Le reti neurali hanno due fasi, una di addestramento e una di inferenza. Durante l’addestramento, la rete neurale impara dai dati forniti, mentre durante l’inferenza cerca di generare risposte in base a ciò che ha appreso.

Tuttavia, le reti neurali, inclusa ChatGPT, hanno una memoria limitata tra un passo e l’altro. Questo può essere un problema, poiché la rete neurale potrebbe dimenticare ciò che è successo tra un passo e l’altro. Questo diventa particolarmente problematico quando dobbiamo generare risposte che richiedono la comprensione del contesto, come durante una conversazione o la lettura di testi lunghi.

Durante la fase di inferenza, la rete neurale potrebbe avere difficoltà a ricordare i dettagli precedenti. Ad esempio, quando dialoghiamo con ChatGPT, vorremmo che il modello ricordasse le informazioni da noi fornite in modo da rispondere coerentemente. Tuttavia, a causa delle limitazioni di memoria, ciò potrebbe non essere sempre garantito.

La memoria è cruciale sia per l’inferenza che per l’addestramento.

- Durante l’addestramento, la rete neurale ha bisogno di memorizzare il contesto per classificare correttamente le frasi.

- Durante l’inferenza, è essenziale che la rete neurale ricordi ciò che è stato discusso in precedenza per generare risposte accurate e coerenti.

Gli scienziati stanno esplorando tecniche di memorizzazione più efficaci e strutture di rete neurali che possano gestire meglio le informazioni nel lungo termine. Questi progressi potrebbero portare a miglioramenti significativi nell’elaborazione dei testi e nella generazione di risposte coerenti.

Le Reti Neurali Ricorrenti

Nelle reti neurali ricorrenti, ogni token elaborato produce un risultato parziale che diventa l’input per il token successivo. Questo aiuta a mantenere il contesto, ma la memoria si deteriora man mano che si procede con la sequenza. Inoltre, questo approccio non può essere parallelizzato, rendendo l’elaborazione lenta.

Le reti a memoria lunga e corta migliorano l’elaborazione sequenziale, assegnando maggiore importanza ai dati rilevanti e dimenticando quelli meno importanti. Tuttavia, anche queste reti presentano limiti: la memoria rimane limitata e l’elaborazione non è parallelizzabile.

I Transformer

Nel 2017, i ricercatori di Google introdussero i Transformer, un nuovo paradigma nell’elaborazione del linguaggio. Questi modelli affrontano il problema della memoria e del contesto in modo innovativo.

Il cuore dei Transformer è il meccanismo di attenzione. Questo concetto si basa sulla nostra stessa abilità di prestare attenzione a dettagli rilevanti mentre ignoriamo il resto. I Transformers analizzano l’intero testo in un unico passaggio, prestando attenzione a parti specifiche per estrarre il contesto.

All’interno dei Transformers, il testo è normalizzato e codificato in token. Da questi token, i vettori incorporati vengono estratti. L’attenzione misura quanto ciascun vettore incorporato è simile alle altre parole nella frase. Questo fornisce informazioni sulla rilevanza di ciascun termine all’interno del contesto.

Attraverso l’attenzione, i Transformers identificano i dettagli più importanti e significativi all’interno del testo. Ad esempio, nella frase “La vita è bella,” il contesto intorno al termine “vita” è estratto, mentre i dettagli meno rilevanti vengono scartati.

L’approccio dei Transformers ha rivoluzionato l’elaborazione del linguaggio, superando le limitazioni delle reti neurali precedenti. Questi modelli sono in grado di mantenere il contesto in testi lunghi e complessi, e l’elaborazione può essere parallelizzata, accelerando il processo.

Il Vettore di Attenzione e la Composizione dei Testi

L’attenzione gioca un ruolo fondamentale nei Transformers. Durante l’elaborazione di ciascuna parola, viene creato un vettore di attenzione che tiene conto delle relazioni tra i token all’interno della frase. Questo vettore guida l’elaborazione successiva, contribuendo a creare testi coerenti e significativi.

Il vettore di attenzione viene utilizzato per mantenere e arricchire il contesto nel processo di elaborazione. Ciò consente al computer di comprendere il significato delle parole all’interno di frasi complesse e di fornire risposte pertinenti. Ad esempio, il computer può riconoscere il riferimento a Caligola e al termine “gatto” con contesti diversi.

Grazie all’attenzione, il computer è in grado di selezionare i termini chiave e rilevanti all’interno del testo. Questi termini hanno maggiore peso nell’analisi e vengono utilizzati per rispondere alle domande, fare riassunti o generare testi coerenti. L’attenzione è quindi un meccanismo cruciale per l’estrazione di concetti chiave.

Un vantaggio notevole dei Transformers è la possibilità di parallelizzare l’elaborazione. A differenza dei modelli sequenziali, l’attenzione non richiede un’elaborazione parola per parola in sequenza. Ogni parola può essere elaborata contemporaneamente, consentendo un addestramento più rapido ed efficiente.

La Rivoluzione dei Transformers e BERT

L’introduzione dei Transformers è stata una vera rivoluzione nell’elaborazione del linguaggio. Google ha giocato un ruolo chiave in questa trasformazione, lanciando modelli basati su Transformers, come BERT. BERT ha migliorato notevolmente l’accuratezza delle ricerche su Google, comprendendo meglio il contesto e fornendo risultati più rilevanti.

OpenAI e la Nascita di GPT

Un gruppo di luminari ha creato OpenAI nel 2015, un’organizzazione senza scopo di lucro per spingere l’intelligenza artificiale oltre i limiti. Tra i fondatori figurano nomi illustri come Sam Altman, co-fondatore di LinkedIn Reid Hoffman e l’innovatore Elon Musk. OpenAI ha dato vita a progetti rivoluzionari, tra cui GPT (Generative Pre-trained Transformer).

GPT è stato uno dei risultati più rilevanti di OpenAI, un modello di generazione del linguaggio basato sui Transformers. Con l’idea di creare la più grande rete neurale mai esistita, GPT sfrutta un vasto numero di parametri regolabili, permettendo di generare testi complessi e coerenti.

Modelli come BERT e GPT hanno rivoluzionato l’elaborazione del linguaggio, portando l’IA a nuove vette di comprensione e generazione testuale. Grazie a GPT, il sistema di ricerca di Google è diventato più potente e accurato, trasformando la ricerca online.

I Limiti dei Grandi Modelli Linguistici

Solitamente, i grandi modelli linguistici sono addestrati con milioni di parametri. Tuttavia, GPT3 è stato portato a nuovi livelli, con 175 miliardi di parametri. Questa macchina potente è stata allenata su una vasta varietà di testi, come Common Crawl, WebText 2 e l’intera Wikipedia, acquisendo una vasta conoscenza che spazia da codici di programmazione agli accordi per chitarra.

Per trasformare GPT3 in ChatGPT, è stato necessario un lavoro più intensivo. GPT3 è stato usato come punto di partenza, ma in questa iterazione, l’approccio è stato più raffinato. Hanno utilizzato dati etichettati per la formazione, un processo noto come apprendimento supervisionato. Questo set di dati includeva risposte di alta qualità scritte da umani.

GPT3 ha generato quattro possibili risposte per ciascuna domanda, che sono state valutate da un gruppo di persone. Questo feedback ha aiutato GPT3 a migliorare le risposte, rendendo il modello più adatto alle esigenze degli utenti umani.

Nascita di ChatGPT

Grazie a queste fasi di addestramento, è stato creato ChatGPT, una versione altamente ottimizzata del modello originale. Ma come funziona ChatGPT?

ChatGPT è in grado di generare risposte coerenti e pertinenti a una vasta gamma di domande e argomenti. Questo modello è stato pubblicato su un sito web, consentendo agli utenti di interagire con un’IA avanzata.

Resta da chiedersi quanto ulteriormente possa essere migliorato GPT. L’aggiunta di un miliardo o 100 trilioni di parametri potrebbe aprire nuove possibilità? Attualmente, il futuro di GPT e dei modelli linguistici avanzati rimane in gran parte incerto, poiché non è chiaro fino a che punto le prestazioni possano essere ottimizzate ulteriormente.

Sfide e Prospettive nell’Evoluzione dell’IA

L’evoluzione dell’IA è un campo dinamico, ma il futuro non è garantito. Nuove architetture, algoritmi e approcci potrebbero emergere nei prossimi anni, portando a scoperte rivoluzionarie o addirittura a una stagnazione. La ricerca continua è fondamentale per rendere l’IA sempre più sofisticata e versatile.

La formazione dell’IA con 175 miliardi di parametri è un processo complesso che richiede risorse significative. Non è qualcosa che può essere facilmente realizzato su un computer domestico. Microsoft, attraverso Azure, ha offerto l’infrastruttura necessaria per l’allenamento di ChatGPT, dimostrando un notevole impegno nell’IA.

Microsoft ha investito 10 miliardi di dollari in OpenAI. Questo ha portato a progetti come GitHub Copilot, che utilizza l’IA per assistere i programmatori nella scrittura del codice.

Bing: La Mossa Audace di Microsoft

Microsoft ha lanciato una versione modificata di ChatGPT su Bing. Questa iniziativa è una diretta sfida a Google, consentendo agli utenti di ottenere risposte coerenti e pertinenti alle loro ricerche attuali. Bing utilizza ChatGPT in modo innovativo, incorporando informazioni in tempo reale dalle ricerche degli utenti.

Mentre Google ha modelli linguistici avanzati, come GPT, è in ritardo rispetto a ChatGPT e Bard è ancora in fase “sperimentale” e non è efficace come il sistema a cui si ispira.

Sfide dell’Apprendimento Automatico

L’IA basata su apprendimento automatico può comportare dei rischi, poiché l’IA apprende dai dati che le vengono forniti, inclusi potenziali pregiudizi o contenuti inappropriati. Inizialmente, GPT ha mostrato difficoltà nel generare risposte sensate e non offensive. Tuttavia, gli sforzi per il controllo e la moderazione sono stati apportati per rendere l’IA più responsabile e sicura.

Nonostante l’entusiasmo, le versioni attuali di ChatGPT, come quella implementata su Bing, presentano limitazioni. L’IA ha difficoltà a garantire sempre risposte accurate e coese, spesso generando informazioni distorte o irreali. Le divagazioni e le associazioni di concetti possono portare a risultati errati o fuorvianti.

ChatGPT non è immune da divagazioni. A causa delle sue capacità di generare concetti correlati, l’IA può spesso combinare informazioni in modi imprecisi o fuorvianti. Ciò può portare a risposte che sembrano corrette superficialmente, ma che non riflettono accuratamente i fatti.

Responsabilità e Disinformazione

L’IA basata su apprendimento automatico presenta sfide etiche e sociali. In passato, ChatGPT ha generato risposte inesatte o offensive. Tuttavia, sono stati fatti sforzi per controllare e mitigare questi problemi. La responsabilità è fondamentale per gestire l’IA in modo etico e sicuro.

L’Intelligenza Artificiale sta affrontando una rivoluzione, con aziende come Microsoft, Google e Apple che investono ingenti risorse in questa tecnologia. Tuttavia, il futuro dell’IA rimane incerto. Nuove architetture, algoritmi e approcci potrebbero essere necessari per raggiungere livelli di intelligenza sempre più sofisticati.

Stiamo assistendo a una competizione tra aziende per la supremazia nell’IA, in particolare nei motori di ricerca semantici e nell’interpretazione dell’Internet. È una sfida per dominare il campo dell’IA e rivoluzionare il modo in cui accediamo e utilizziamo le informazioni online.

Conclusioni

L’IA rappresenta una realtà in evoluzione che offre opportunità e sfide uniche. Mentre l’entusiasmo cresce, è essenziale esaminare le limitazioni e gestire le conseguenze delle risposte dell’IA e di ChatGPT. La ricerca e l’innovazione continueranno a guidare l’IA verso un futuro di possibilità ancora inimmaginate. Ti invito a sperimentare, a esplorare e a mantenere uno sguardo critico su ciò che l’IA può offrire, senza prendere per oro colato tutto ciò che dice, specialmente adesso sai come funziona ChatGPT e cos’è realmente un’Intelligenza Artificiale.

Share this content: